GPU端到端目标检测YOLOV3全过程(上)

GPU端到端目標檢測YOLOV3全過程(上)

Basic Parameters:

Video: mp4, webM, avi

Picture: jpg, png, gif, bmp

Text: doc, html, txt, pdf, excel

Video File Size: not more

than 10GB

batch=16, subdivisions=1

Resolution: 416 * 416, 320 * 320.

Frame: 45f/s with 320 * 320. At 320 ×

320 YOLOv3 runs in 22 ms at 28.2 mAP, as accurate as SSD but three times

faster.

AI Framework:TensorFlow,

Pytorch, Mxnet, Caffe

Programming Lanuage: Python/C/C++/Java

Accept:

application/json, text/plain, /

Accept-Language:

en-US, en;

Files Input Parameters of Test Model : .model,.weight

Files Input Parameters of Train Model : Filename,

Path, Resolution,…

Files Output Parameters of Train Model : .model,.weight

Files Output Parameters of Test Model : Class

Number,Class Name,mAP value

Hardware: VGA,

DVI, HDMI, DP, SDI, BNC, WIFI, Bluetooth, USB, CAN, Socket, PCIE, SD Card,

Serial Port, Clock Time, SPI, Uart, I2C/I2S, GPIO, Touch Ctrl, LCD, LED, EMMC,

SATA, Audio ADC

Dependency Library: v4l2(Video for linux2),ffmpeg,VLC media player,opencv,

CUDA,cudann,Tensorflow,Pytorch,Mxnet,Caffe,Ubuntu,

darknet,udp/tcp,H264、AAC,rtmp、rtp/rtcp,ffmpeg、x264、

WebRTC、GStreamer,NEON、OpenCL、OpenGL ES,

MongoDB/MySQL/Redis,

dataset:coco,kitti,VOC

lanuage:python/c/c++

圖像分類經典網絡模型

LeNet-5

AlexNet

VGG-16/VGG-19

GoogLeNet

Inception v3/v4

ResNet

preResNet

ResNeXt

SENet

目標檢測網絡模型:

R-CNN(Region-CNN)

SPP Net

Fast R-CNN

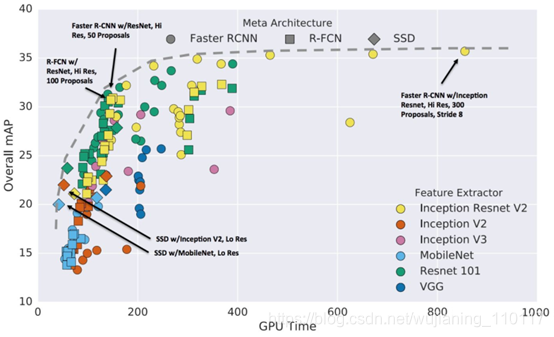

Faster R-CNN

R-FCN

YOLO

SSD

FPN

RetinaNet

目標檢測常用數據集

Pascal VOC: http://host.robots.ox.ac.uk/pascal/VOC/

MS COCO : http://cocodataset.org/#home

KITI:

http://www.cvlibs.net/datasets/kitti/eval_object.php?obj_benchmark=2d

ImageNet:

http://www.image-net.org/

Berkeley發布BDD100K: bdd-data.berkeley.edu/#download-section

語義分割(semantic segmentation)

Mask R-CNN

FCN

SegNet

Unet

DeepLab

RefineNet

PSPNet

GCN

DeepLabV3 ASPP

GAN

目標檢測常用數據集

Pascal VOC: http://host.robots.ox.ac.uk/pascal/VOC/

MS COCO : http://cocodataset.org/#home

KITI: http://www.cvlibs.net/datasets/kitti/eval_object.php?obj_benchmark=2d

Cityscapes:https://www.cityscapes-dataset.com/dataset-overview/#features

ImageNet: http://www.image-net.org/

Berkeley發布BDD100K:

bdd-data.berkeley.edu/#download-section

NYUDv2:https://cs.nyu.edu/~silberman/datasets/nyu_depth_v2.html

SUN-RGBD:http://rgbd.cs.princeton.edu/

ADE20K_MIT:http://groups.csail.mit.edu/vision/datasets/ADE20K/

名稱

優點

缺點

FCN

可以接受任意大小的圖像輸入;避免了采用像素塊帶來的重復存儲和計算的問題

得到的結果不太精確,對圖像的細節不敏感,沒有考慮像素與像素之間的關系,缺乏空間一致性

SegNet

使用去池化對特征圖進行上采樣,在分割中保持細節的完整性;去掉全連接層,擁有較少的參數

當對低分辨率的特征圖進行去池化時,會忽略鄰近像素的信息

Deconvnet

對分割的細節處理要強于 FCN,位于低層的filter 能捕獲目標的形狀信息,位于高層的 filter能夠捕獲特定類別的細節信息,分割效果更好

對細節的處理難度較大

U-net

簡單地將編碼器的特征圖拼接至每個階段解碼器的上采樣特征圖,形成了一個梯形結構;采用跳躍連接架構,允許解碼器學習在編碼器池化中丟失的相關性

在卷積過程中沒有加pad,導致在每一次卷積后,特征長度就會減少兩個像素,導致網絡最后的輸出與輸入大小不一樣

DeepLab

使用了空洞卷積;全連接條件隨機場

得到的預測結果只有原始輸入的 1/8 大小

RefineNet

帶有解碼器模塊的編碼器-解碼器結構;所有組件遵循殘差連接的設計方式

帶有解碼器模塊的編碼器-解碼器結構;所有組件遵循殘差連接的設計方式

PSPNet

提出金字塔模塊來聚合背景信息;使用了附加損失

采用四種不同的金字塔池化模塊,對細節的處理要求較高

GCN

提出了帶有大維度卷積核的編碼器-解碼器結構

計算復雜,具有較多的結構參數

DeepLabV3 ASPP

采用了Multigrid;在原有的網絡基礎上增加了幾個 block;提出了ASPP,加入了 BN

不能捕捉圖像大范圍信息,圖像層的特征整合只存在于 ASPP中

GAN

提出將分割網絡作為判別器,GAN 擴展訓練數據,提升訓練效果;將判別器改造為 FCN,從將判別每一個樣本的真假變為每一個像素的真假

沒有比較與全監督+半監督精調模型的實驗結果,只體現了在本文中所提創新點起到了一定的作用,但并沒有體現有效的程度

人臉識別

網絡模型:

dlib

mtcnn

DeepFace

OpenFace

DeepID

Facenet

VGGFace

?

人臉識別常用數據集大全

?

哥倫比亞大學的公眾人物臉部數據集: PubFig: Public Figures Face Database

?

香港中文大學大型人臉識別數據集: Large-scale CelebFaces Attributes (CelebA) Dataset

?

color FERET Database:

https://www.nist.gov/itl/products-and-services/color-feret-database

?

Multi-Task Facial Landmark (MTFL) dataset: http://mmlab.ie.cuhk.edu.hk/projects/TCDCN.html

x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L3d1amlhbmluZ18xMTAxMTc=,size_16,color_FFFFFF,t_70#pic_center)

?

Video Codec

?

H264/H265/H266

?

Ffmpeg/Gstream/OpenMax

流媒體(Streaming Media)技術是指將一連串的媒體數據壓縮后,以流的方式在網絡中分段傳送,實現在網絡上實時傳輸影音以供觀賞的一種技術。

流媒體實際指的是一種新的媒體傳送方式,有聲音流、視頻流、文本流、圖像流、動畫流等,而非一種新的媒體。

流媒體文件格式是支持采用流式傳輸及播放的媒體格式。常用格式有:RA:實時聲音;RM:實時視頻或音頻的實時媒體;RT:實時文本;RP:實時圖像;SMII.:同步的多重數據類型綜合設計文件;SWF:real flash和shockwavc

flash動面文件;RPM: HTMI。文件的插件;RAM:流媒體的源文件,是包含RA、RM、SMIIJ文件地址(URL地址)的文本文件;CSF:一種類似媒體容器的文件格式,可以將非常多的媒體格式包含在其中,而不僅僅限于音、視頻。quicktime,mov,asf,wmv,wma,avi,mpeg,mpg,dat,mts; aam多媒體教學課件格式,可將authorware生成的文件壓縮為aam和aas流式文件播放。

總結

以上是生活随笔為你收集整理的GPU端到端目标检测YOLOV3全过程(上)的全部內容,希望文章能夠幫你解決所遇到的問題。

- 上一篇: 如何使用Intel vtune prof

- 下一篇: GPU端到端目标检测YOLOV3全过程(